随着人工智能技术从概念走向大规模落地应用,人工智能应用软件的开发与测试已成为行业关注的焦点。位于中国西南科技重镇成都的汇智动力,作为一家深耕IT职业教育与技术服务的企业,敏锐地捕捉到这一趋势,将传统软件测试的深厚积淀与人工智能领域的独特需求相结合,探索出了一条具有前瞻性的实践路径。

一、 人工智能应用软件测试的新挑战

与传统软件相比,人工智能应用软件(尤其是基于机器学习、深度学习模型的应用)的核心“智能”部分具有非确定性、数据驱动和持续演进的特点。这给软件测试带来了前所未有的挑战:

- 测试对象的复杂性:测试重点从确定的逻辑流程,转向了模型在大量输入下的行为、准确性(如精确率、召回率)、鲁棒性及公平性。

- 数据依赖性强:模型的性能高度依赖于训练数据和测试数据。测试需要覆盖多样的数据分布、边缘案例,并防范数据偏见。

- “正确”标准的模糊性:对于分类或识别任务,存在可量化的指标;但对于生成式AI(如对话、创作),其输出质量的评估更主观,需要结合人工评估与自动化指标。

- 持续学习与迭代:模型在线学习和更新,要求测试流程能够嵌入CI/CD(持续集成/持续部署)管道,实现自动化、常态化的质量监控。

二、 成都汇智动力的融合实践

针对这些挑战,汇智动力在其课程体系与技术解决方案中,强调“测试左移”和“AI赋能测试”的双向融合。

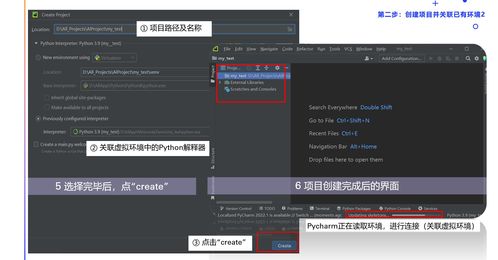

- 构建专业人才知识体系:在软件测试人才培养中,汇智动力率先融入AI测试模块。学员不仅学习Python编程、自动化测试框架,还需掌握机器学习基础、常见AI模型(如CNN、RNN)的工作原理,以及如何设计测试用例来验证模型性能。例如,学习如何利用对抗性样本测试模型的鲁棒性,或使用A/B测试框架评估不同模型版本的效果。

- 倡导全生命周期的AI测试策略:

- 数据测试:在模型开发前期,强调对训练数据质量、标注一致性、分布均衡性进行严格测试与验证。

- 模型评估测试:不仅关注整体准确率,更深入讲解混淆矩阵、ROC曲线、F1值等指标,并引入对模型公平性、可解释性的测试考量。

- 系统集成测试:将训练好的模型作为组件,嵌入完整的应用软件(如智能客服系统、图像识别APP)中,进行端到端的集成测试、性能测试和用户体验测试。

- 监控与回归测试:教授如何构建自动化监控流水线,对线上模型的预测效果进行实时监控,一旦出现性能衰减或数据漂移,能快速触发警报和回归测试。

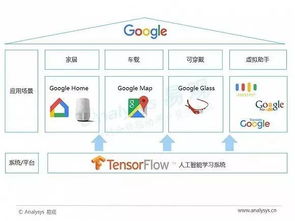

- 工具链的探索与应用:引导学员熟悉和运用新兴的AI测试工具与框架,如用于模型评估的MLflow、用于公平性检测的AI Fairness 360,以及用于生成对抗性测试样本的TensorFuzz等,提升测试效率与深度。

三、 未来展望:测试工程师的AI化与AI的测试化

成都汇智动力认为,人工智能应用软件测试的未来是双向赋能的:

一方面,测试工程师需要“AI化”。未来的测试专家必须理解AI,能够与数据科学家、算法工程师有效沟通,设计出针对智能特性的测试方案,成为保障AI产品质量的关键角色。

另一方面,AI技术也在“测试化”。利用AI(如自然语言处理、计算机视觉)来增强测试能力本身,例如自动生成测试用例、智能分析测试日志、自动识别UI异常等,实现测试活动的智能化升级。

****

在成都这座充满创新活力的城市,汇智动力正通过其教育与实践,推动软件测试领域与人工智能的深度融合。人工智能应用软件的测试不再是事后的简单验证,而是贯穿于数据、模型、系统全周期的质量保障工程。这不仅是技术能力的升级,更是质量保障思维的革新。随着更多具备AI测试技能的专业人才从这里走向产业,他们将为确保人工智能应用可靠、可信、负责任地服务于社会贡献关键力量。